前面的Web3 X 去中心化科學DeSci-重構雲服務其實就是在討論一個市場風氣的變化,畢竟數位時代將是不會回頭的趨勢,儲存是剛需,而價錢則是重要客戶的選擇,雖然全球硬碟和伺服器上存儲和維護能力持續進化,但是每年產生的數據量也同步以驚人的速度增加。到2021年,全球人民創建了超過7900萬 terabytes,只有約0.015%的數據存儲在Google、Amazon和Facebook等巨頭的服務。

相比之下,較小的數據比例存儲在如Filecoin、Storj和BitTorrent等分散式存儲解決方案上,它們宣稱提供能夠持續數百年的永久存儲。隨著這些存儲網絡不斷擴大其容量,它們成為個人用戶和公司替代存儲解決方案的更具吸引力的選擇,並增加了數據安全性和韌性。

近年來,分散式存儲網絡的生態系統迅速增長,每個都有其自己的應用程式套件。對於一些DeFi和NFT項目,它們已成為托管永久和無許可數據的首選,並在加密空間內強調反審查的核心理念。為了了解它們的增長情況,我們深入研究了分散式存儲的現狀。

那在這個大浪潮下,一定會有越來越多去中心化儲存項目出現,那我們可以從哪些方向來快速了解這些項目的差異,並且從中規劃適合自己的需求呢?我們可以用下面幾點來評估這類分散式存儲(dStorage)選項:

基本上稱為去中心化儲存項目就代表它必須要有一套機制來維持其分散機制,目前主要可以分為 區塊鏈機制(blockchain-based) 和 合約機制(contract-based),區塊鏈機制(blockchain-based)主要重點是在每個節點中都保存數據,確保數據的安全和永久性,為了保持這類的永續幸,通常項目都必須要有一套機制來對所有數據做驗證。例如,在以太坊上的資料就採用這種全節點保存和持久性機制,所以就必須要對整個鏈進行核算。新的數據被添加到鏈的末尾,且鏈持續增長 - 要求每個節點都復制所有內嵌的數據。這被稱為基於區塊鏈的持久性。基於區塊鏈的持久性的問題是鏈可能變得太大,難以合理地維護和存儲所有數據(例如,許多資料估計互聯網需要超過40 Zetabytes的存儲容量)。區塊鏈還必須有某種激勵結構。對於基於區塊鏈的持久性,驗證者會收到付款。當數據被添加到鏈上時,支付給驗證者以將數據加上。

目前以太坊和Areave就是這類的儲存模式。

合約機制(contract-based) 的去中心化儲存項目則是假設資料不可能在每一個節點都做複製,而是使用合約協議來維護資料,實務上就是讓多個節點藉由合約來承諾每段時間內需要保存特定的資料方式來確定資料一致性。當合約內時間到期後,則必須要在使用合約來做延續或是取消合約內保證保存的資料。在大多數情況下,不是將所有數據都存儲在鏈上,而是存儲數據在鏈上位置的哈希值。這樣,整個鏈不需要擴展以保存所有數據。

大多數新的去中心化儲存項目都是以這方向為主,因為實際上,不太可能讓每個節點都備份一次,否則在對於節點的空間要求會越來越高,到最後可能費用會昂貴到不符合實務需求。

目前以這類項目為主的有:Filecoin、Skynet、Storj、0Chain、Crust Network、Swarm、4EVERLAND、BitTorrent。

為了保留數據,系統必須有某種機制來確保數據得到保留。確保數據保留的最受歡迎的方法之一是使用某種 挑戰機制 ,也就是會發給節點一些挑戰或是考試,以確保它們是否仍然擁有數據。

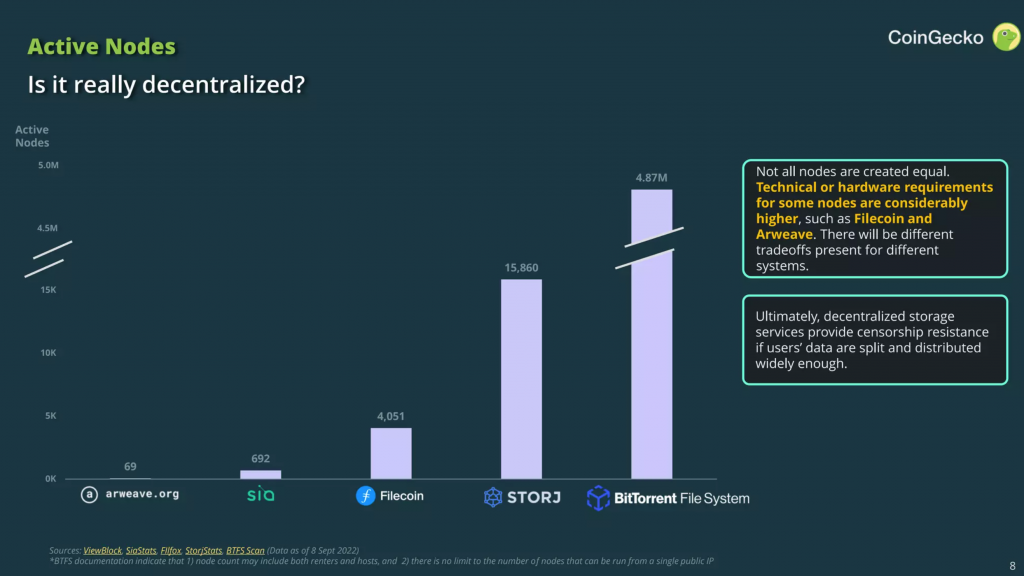

這塊則是去看每個項目其有多少節點在網路之中,我們可以參考一下目前幾個大項目在這點的評比,可以發現目前聲勢最大的Filecoin其實就節點數來說並非最多最分散的,這就可能跟每個項目對驗證或是儲存提供節點的需求和資料分散式儲存的機制有關。

區塊鏈最重要的一個機制就是節點間怎麼去對鏈上資料行成確認和驗證,就是所謂的共識機制(Consensus Mechanism),指允許節點網絡同意區塊鏈狀態的一整套協議、激勵和觀念。之前以太坊有一個很重大的調整,就是把他們共識機制中的驗證機制由工作量證明改成質押證明,可以從剛出掀起的超大波瀾知道這是區塊鏈項目中很重要的機制特性,也會決定一個區塊鏈的特色,其中會有如何選擇節點的驗證者來提議或驗證區塊、處理交易和投票選擇鏈的驗證節點,同時這也跟鏈的安全性有關。

閱讀參考:

Decentralized Storage

Filecoin Docs

我們的基因體時代是我經營的部落格,如有對於合成生物學、生物資訊、檢驗醫學、資料視覺化、R語言有興趣的話,可以來交流交流!也可以追蹤我的工作IG,但就是偏向醫療為主,假如對去中心化科學有興趣,則可以進入到g0v的da0頻道中多多交流。